Clusteranalyse

Leitfaden mit

Beispielen

Entdecken Sie die Leistungsfähigkeit der Clusteranalyse mit unserem umfassenden Leitfaden. Lernen Sie die Definition, Arten und Beispiele dieser statistischen Methode kennen, um Einblicke in komplexe Beziehungen in Ihren Daten zu erhalten.

Die Clusteranalyse ist eine weit verbreitete statistische Methode zur Identifizierung von Gruppen ähnlicher Objekte innerhalb eines Datensatzes. Sie ist damit ein wertvolles Instrument in Bereichen wie Marktforschung, Biologie und Psychologie. In diesem Leitfaden definieren wir den Begriff der Clusteranalyse, untersuchen ihre verschiedenen Arten und geben praktische Beispiele für ihre Anwendung. Am Ende dieses Leitfadens werden Sie ein umfassendes Verständnis der Clusteranalyse und ihrer Vorteile haben. Sie werden fundierte Entscheidungen treffen können, wenn es um die Analyse Ihrer eigenen Daten geht.

Was ist eine Clusteranalyse?

Die Clusteranalyse ist eine statistische Methode, die dazu dient, Elemente auf der Grundlage ihrer engen Beziehung zueinander in Clustern zusammenzufassen. Es handelt sich dabei um eine explorative Analyse, die Strukturen innerhalb von Datensätzen identifiziert und versucht, homogene Gruppen von Fällen zu ermitteln. Die Clusteranalyse kann binäre, nominale, ordinale und skalierte Daten verarbeiten. Sie wird häufig in Verbindung mit anderen Analysen wie der Diskriminanzanalyse eingesetzt. Der Zweck der Clusteranalyse besteht darin, ähnliche Gruppen von Subjekten auf der Grundlage eines globalen Maßes über den gesamten Satz von Merkmalen zu finden.

Die Clusteranalyse findet in der Praxis zahlreiche Anwendungen, zum Beispiel beim unüberwachten maschinellen Lernen, Data Mining, in der Statistik, bei Graph Analytics, in der Bildverarbeitung und in zahlreichen physikalischen und sozialwissenschaftlichen Anwendungen. Im Marketing wird die Clusteranalyse verwendet, um Kunden auf der Grundlage ihres Kaufverhaltens oder ihrer Präferenzen in Gruppen zu unterteilen. Im Gesundheitswesen identifiziert die Clusteranalyse Patientenuntergruppen mit ähnlichen Merkmalen oder Behandlungsergebnissen. Im Handel mit Anlegern wird die Clusteranalyse verwendet, um ein diversifiziertes Portfolio zu entwickeln: Aktien, die verschiedene Korrelationen der Renditen aufweisen, werden in unterschiedliche Körbe gelegt.

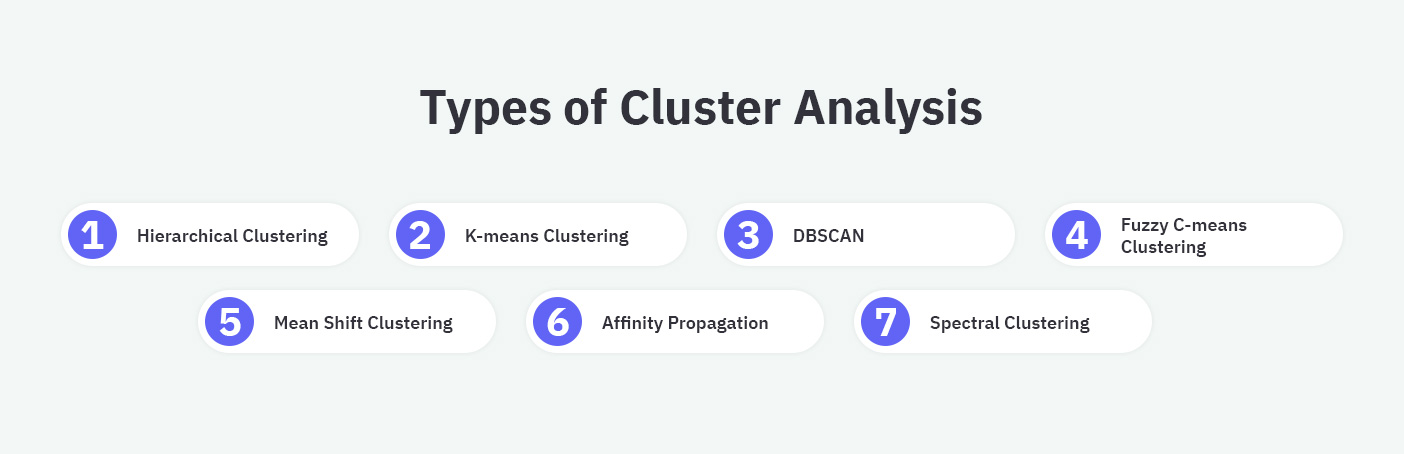

Arten der Clusteranalyse mit Beispielen

Hierarchisches Clustering

Das hierarchische Clustering basiert auf dem Konzept der Erstellung einer Hierarchie von Clustern. Diese Methode umfasst entweder einen agglomerativen (Bottom-up) oder einen divisiven (Top-down) Ansatz. Das agglomerative Clustering beginnt mit einzelnen Datenpunkten als Clustern und führt diese iterativ auf der Grundlage der Ähnlichkeit zusammen. Das divisive Clustering beginnt mit einem Cluster, der alle Datenpunkte enthält, und teilt diesen nach und nach auf. Das Ergebnis ist ein Dendrogramm, eine baumartige Struktur, die die verschachtelte Gruppierung von Clustern darstellt.

Beispiel: Hierarchisches Clustering kann angewendet werden, um ähnliche Dokumente auf der Grundlage ihres Inhalts zu gruppieren. So können Forscher beispielsweise eine große Menge von Nachrichtenartikeln analysieren und sie nach Themen wie Sport, Politik und Unterhaltung gruppieren. Dies hilft den Benutzern dabei, effizienter zu navigieren und Inhalte zu erkunden.K-means-Clustering

Das K-means-Clustering ist eine weit verbreitete zentrumsbasierte Partitionierungsmethode. Bei dieser Methode gibt der Benutzer die Anzahl der Cluster (k) vor. Der Algorithmus ordnet die Datenpunkte dem nächstgelegenen Schwerpunkt zu und berechnet dann die Position des Schwerpunkts neu, bis Konvergenz erreicht ist. Diese Methode ist für ihre Einfachheit und Effizienz bekannt, insbesondere bei großen Datensätzen.

Beispiel: Unternehmen verwenden das K-means-Clustering, um ihren Kundenstamm anhand verschiedener Merkmale wie Alter, Einkommen und Kaufhistorie zu segmentieren. Die unterschiedlichen Segmente helfen den Unternehmen dabei, ihre Marketingstrategien und Produktangebote besser auf die jeweiligen Bedürfnisse der Kunden abstimmen.DBSCAN (Density-Based Spatial Clustering of Applications with Noise)

DBSCAN ist ein dichtebasierter Clustering-Algorithmus, der Datenpunkte in Bereichen mit hoher Dichte zusammenfasst und gleichzeitig Rauschen identifiziert und trennt. Er erfordert keine vordefinierte Anzahl von Clustern, da er auf der Grundlage der Dichteverteilung der Daten beliebige Formen und Größen von Clustern finden kann. DBSCAN ist besonders nützlich für Datensätze mit Rauschen oder Cluster mit unterschiedlicher Dichte.

Beispiel: DBSCAN wird bei der Analyse von Netzwerkverkehrsdaten eingesetzt. Der Algorithmus erkennt ungewöhnliche Muster oder Ausreißer, die auf potenzielle Sicherheitsbedrohungen oder Netzwerkprobleme hinweisen. Durch die Gruppierung von Datenpunkten auf der Grundlage ihrer Dichte trennt der Algorithmus normalen Datenverkehr von anomalen Ereignissen.Fuzzy C-means Clustering

Fuzzy C-means ist eine Variante des K-means-Algorithmus. Sie ordnet Datenpunkte Clustern mit unterschiedlichen Zugehörigkeitsgraden zu. Diese Methode erlaubt überlappende Cluster und ermöglicht damit ein differenzierteres Verständnis der Datenbeziehungen. Fuzzy C-means wird häufig in der Bildverarbeitung, der Mustererkennung und anderen Situationen eingesetzt, in denen Datenpunkte nicht notwendigerweise zu einer eindeutigen Gruppe gehören.

Beispiel: Fuzzy C-means Clustering kann für die Bildsegmentierung verwendet werden. Das Ziel besteht darin, ein Bild in Regionen zu unterteilen, die ähnliche Merkmale aufweisen. Indem jedem Pixel ein Zugehörigkeitsgrad zu mehreren Clustern zugewiesen wird, kann der Algorithmus weiche Übergänge zwischen den Regionen erzeugen. Das Ergebnis sind genauere und visuell ansprechende Segmentierungen.Mean Shift Clustering

Mean Shift ist ein nicht-parametrischer, auf einem gleitenden Fenster basierender Clustering-Algorithmus, der Datenpunkte lokalisiert und in Richtung der dichtesten Region in ihrer Umgebung verschiebt. Er ist besonders nützlich für die Identifizierung von Clustern in Datensätzen mit einer unbekannten Anzahl von Clustern oder unterschiedlichen Clusterformen und -dichten.

Beispiel: Mean Shift Clustering kann auf die Objektverfolgung in Videosequenzen angewendet werden. Durch die iterative Verschiebung von Datenpunkten in Richtung der dichtesten Region lokalisiert und verfolgt der Algorithmus Objekte, während sie sich über Bilder hinweg bewegen. Diese Technik ist nützlich für Anwendungen wie Videoüberwachung, Sportanalyse und Computer-Vision-Projekte.Affinity Propagation

Affinity Propagation ist ein Clustering-Algorithmus, der dieExemplare

oder repräsentativen Datenpunkte für jedes Cluster identifiziert. Er funktioniert durch iterative Aktualisierung der Matrizen Verantwortung und Verfügbarkeit, die die Ähnlichkeit zwischen Datenpunkten und potenziellen Exemplaren bestimmen. Diese Technik eignet sich für Datensätze mit einer unbekannten Anzahl von Clustern. Sie wird häufig in Bereichen wie Computer Vision und Netzwerkanalyse eingesetzt.

Beispiel: Affinity Propagation wird häufig zur Analyse sozialer Netzwerke und zur Ermittlung einflussreicher Mitglieder oder Gemeinschaften innerhalb des Netzwerks eingesetzt. Durch das Clustern von Nutzern auf der Grundlage ihrer Verbindungen und Interaktionen deckt der Algorithmus zugrundeliegende Muster und Strukturen auf. Dadurch liefert er wertvolle Erkenntnisse für Marketingkampagnen oder soziologische Untersuchungen.Spektrales Clustering

Spektrales Clustering ist eine Technik, die die Eigenwerte einer Ähnlichkeitsmatrix nutzt, um die Dimensionalität zu reduzieren, bevor ein Clustering-Algorithmus wie K-means angewendet wird. Diese Methode ist besonders effektiv für Datensätze, bei denen die Cluster nicht unbedingt linear trennbar sind oder komplexe Strukturen aufweisen.

Beispiel: Spektrales Clustering wird verwendet, um Bilder mit ähnlichen Inhalten oder visuellen Merkmalen zu gruppieren. Durch die Umwandlung der Bilddaten in einen niedrigdimensionalen Raum kann der Algorithmus Bilder mit komplexen Mustern oder Strukturen effektiv identifizieren und clustern. Das macht ihn zu einem nützlichen Werkzeug für Anwendungen wie inhaltsbasierte Bildsuche und -organisation.

Clusteranalysen mit resonio optimieren

Nutzen Sie resonios Marktforschungstool, um gezielt Daten zu erheben, Umfrageteilnehmer zu befragen und Clusteranalysen durchzuführen. Identifizieren Sie relevante Zielgruppensegmente für fundierte Geschäftsentscheidungen.

Mehr über resonios MarktforschungstoolTechnische Herausforderungen und Lösungsansätze bei der Clusteranalyse

Trotz ihrer vielfältigen Anwendungsmöglichkeiten und Vorteile bringt die Clusteranalyse einige technische Herausforderungen mit sich, die sowohl die Durchführung als auch die Qualität der Ergebnisse. Hier diskutieren wir häufig auftretende Probleme und bieten bewährte Methoden zur Überwindung dieser Herausforderungen an.

Skalierbarkeit und Rechenintensität

Einer der Hauptprobleme bei der Clusteranalyse, besonders bei großen Datensätzen, ist die Skalierbarkeit. Viele Clustering-Algorithmen, insbesondere solche, die auf Distanzberechnungen basieren, wie das hierarchische Clustering, erfordern erhebliche Rechenleistung, die mit zunehmender Datenmenge exponentiell ansteigt.

Lösungsansätze:

- Verwendung von effizienteren Algorithmen: Algorithmen wie K-means oder DBSCAN sind bekannt für ihre Effizienz bei großen Datenmengen.

- Dimensionalitätsreduktion: Techniken wie PCA (Principal Component Analysis) können verwendet werden, um die Datenmenge zu reduzieren, während die wichtigsten Informationen beibehalten werden.

- Sampling: Durch die Auswahl repräsentativer Stichproben aus einem großen Datensatz können Clusteranalysen effizienter gestaltet werden, ohne die Gesamtergebnisse wesentlich zu beeinträchtigen.

Sensibilität gegenüber Ausreißern

Clusteranalyse-Methoden können empfindlich auf Ausreißer reagieren, insbesondere Algorithmen wie K-means, die auf den Mittelwerten der Cluster basieren. Ausreißer können die Clusterzentren erheblich verschieben und somit zu irreführenden Ergebnissen führen.

Lösungsansätze:

- Robuste Clustering-Verfahren: Verwenden von Algorithmen wie DBSCAN oder Mean-Shift, die natürlicherweise gut mit Ausreißern umgehen können, da sie auf Dichteschätzungen basieren.

- Vorverarbeitung der Daten: Anwenden von Methoden zur Ausreißererkennung und -entfernung, bevor die Clusteranalyse durchgeführt wird.

Bestimmung der Anzahl der Cluster

Die Festlegung der Anzahl der Cluster im Voraus ist bei vielen Algorithmen erforderlich und kann problematisch sein, da diese nicht immer offensichtlich aus den Daten hervorgeht.

Lösungsansätze:

- Elbow-Methode: Diese Methode betrachtet die Variabilität als Funktion der Clusterzahl und sucht nach einem „Knick“ (Elbow), der den geeigneten Kompromiss zwischen Komplexität und Genauigkeit der Clusterung anzeigt.

- Silhouetten-Score: Diese Metrik bewertet, wie ähnlich ein Objekt zu seinem eigenen Cluster im Vergleich zu anderen Clustern ist, was hilft, die optimale Clusteranzahl zu bestimmen.

- Cross-Validation: Ähnlich wie bei anderen maschinellen Lernansätzen kann die Kreuzvalidierung verwendet werden, um die Stabilität der Clustering-Ergebnisse über verschiedene Clusteranzahlen hinweg zu bewerten.

Abhängigkeit von der Wahl der Distanzmetrik

Die Wahl der Distanzmetrik kann einen entscheidenden Einfluss auf die Bildung der Cluster haben. Unterschiedliche Metriken wie Euklidische, Manhattan oder Kosinus-Distanz können zu verschiedenen Clustering-Ergebnissen führen.

Lösungsansätze:

- Auswahl basierend auf dem Datentyp: Die Auswahl der Distanzmetrik sollte basierend auf der Art der Daten getroffen werden (z.B. binäre, kategoriale oder kontinuierliche Daten).

- Experimentieren mit verschiedenen Metriken: Durch das Testen verschiedener Distanzmetriken kann evaluiert werden, welche Metrik die sinnvollsten und konsistentesten Clustering-Ergebnisse liefert.

Anwendungsbeispiele der Clusteranalyse in verschiedenen Branchen

Die Clusteranalyse ist eine vielseitige Technik, die branchenübergreifend eingesetzt wird, um aus großen Datenmengen sinnvolle Einsichten zu gewinnen. Durch die Gruppierung ähnlicher Datenpunkte können Organisationen Muster erkennen, die sonst verborgen bleiben würden. Hier sind einige konkrete Beispiele, wie verschiedene Sektoren von der Clusteranalyse profitieren:

Clusteranalyse im Marketing: Verständnis von Verbraucherverhalten

Marketingexperten verwenden die Clusteranalyse, um Verbraucherverhalten und -präferenzen besser zu verstehen. Durch die Analyse von Clustern, die auf Kaufverhalten, Nutzungsmustern von Diensten und Feedback zu Produkten basieren, können Unternehmen effektivere Kampagnen gestalten, die resonieren und die Kundenbindung stärken.

Einzelhandel: Kundensegmentierung für personalisiertes Marketing

Im Einzelhandel wird die Clusteranalyse verwendet, um Kunden basierend auf ihren Kaufgewohnheiten, Vorlieben und demografischen Merkmalen in verschiedene Gruppen zu segmentieren. Diese Informationen ermöglichen es Einzelhändlern, maßgeschneiderte Marketingstrategien zu entwickeln, die auf die spezifischen Bedürfnisse und Wünsche jeder Gruppe zugeschnitten sind. Beispielsweise könnte ein Einzelhändler feststellen, dass eine Gruppe von Kunden häufig Bio-Produkte kauft und gezielt Werbeaktionen für diese Produktkategorie an diese Gruppe senden.

Finanzsektor: Risikomanagement und Betrugserkennung

Banken und Finanzinstitutionen nutzen Clusteranalysen, um Kunden nach Risikoprofilen zu klassifizieren. Durch die Identifizierung von Clustern innerhalb der Kreditportfolios können Banken ihre Risikoexposition besser managen und präventive Maßnahmen ergreifen. Zudem ist die Clusteranalyse ein wertvolles Werkzeug zur Betrugserkennung, indem sie hilft, ungewöhnliche Transaktionsmuster zu erkennen, die auf betrügerische Aktivitäten hinweisen könnten.

Clusteranalyse im Gesundheitswesen: Patientenmanagement und Behandlungsoptimierung

Im Gesundheitswesen ermöglicht die Clusteranalyse eine effiziente Gruppierung von Patienten mit ähnlichen medizinischen Bedingungen oder Behandlungsergebnissen. Diese Segmentierung unterstützt Gesundheitsdienstleister bei der Entwicklung personalisierter Behandlungspläne und verbessert die Patientenversorgung. Beispielsweise können Patienten mit ähnlichen Symptomen oder Reaktionen auf bestimmte Medikamente identifiziert und entsprechend spezifisch behandelt werden.

Logistik: Optimierung der Lieferketten

In der Logistik wird die Clusteranalyse eingesetzt, um Liefer- und Versandprozesse zu optimieren. Unternehmen können ihre Kunden und deren Lieferorte in Cluster einteilen, um Routen effizienter zu planen und die Lieferzeiten zu verkürzen. Dies führt zu Kostenreduktion und verbessertem Kundenservice.

Vorteile der Clusteranalyse

- Verborgene Muster und Trends erkennen

Einer der Hauptvorteile der Clusteranalyse ist die Fähigkeit, verborgene Muster und Trends in Datensätzen aufzudecken. Durch die Gruppierung ähnlicher Datenpunkte hilft die Clusteranalyse den Nutzern bei der Aufdeckung von Beziehungen und Strukturen, die vielleicht nicht sofort ersichtlich sind. - Verbesserte Entscheidungsfindung

Die Clusteranalyse ermöglicht es Unternehmen, fundiertere Entscheidungen zu treffen. Denn sie liefert ein klares Verständnis der Beziehungen und Muster innerhalb der Daten. Durch die Identifizierung von Clustern können Entscheidungsträger ihre Ressourcen gezielter einsetzen. Sie können maßgeschneiderte Marketingstrategien entwickeln und das Produktangebot optimieren, um die Bedürfnisse verschiedener Kundensegmente oder Marktnischen zu erfüllen. - Datenorganisation und -visualisierung

Mithilfe der Clusteranalyse können Sie komplexe Datensätze vereinfachen, indem Sie die Datenpunkte in sinnvolle Gruppen einteilen. Diese Ordnung erleichtert die Visualisierung und Analyse großer Datenmengen und ermöglicht es den Benutzern, Trends, Ausreißer und potenziell interessante Bereiche schnell zu erkennen. Darüber hinaus kann Clustering zur Erstellung effektiverer Datenvisualisierungen verwendet werden, zum Beispiel Heatmaps oder Dendrogramme, die die Kommunikation und das Verständnis datengesteuerter Erkenntnisse verbessern. - Bessere Kundensegmentierung

Durch die Anwendung der Clusteranalyse auf Kundendaten können Unternehmen ihren Kundenstamm anhand verschiedener Attribute wie Demografie, Kaufverhalten und Produktpräferenzen in unterschiedliche Gruppen einteilen. Diese Segmentierung ermöglicht es Unternehmen, ihre Marketingstrategien und Produktangebote besser auf die Bedürfnisse unterschiedlicher Kundensegmente abzustimmen. Das erhöht die Kundentreue und Kundenzufriedenheit. - Anomalien identifizieren

Mit der Cluster-Analyse lassen sich Ausreißer oder Anomalien in Datensätzen erkennen. Das hilft bei der Bekämpfung von Betrug und verhindert den Ausfall von Geräten oder Netzwerken. Durch die Gruppierung von Datenpunkten auf der Grundlage ihrer Ähnlichkeiten trennt die Cluster-Analyse normale Daten effektiv von anomalen Ereignissen. Unternehmen können dadurch potenzielle Probleme schneller erkennen. - Optimierung der Ressourcenzuweisung

In Branchen wie der Logistik, der Fertigung oder der Stadtplanung kann die Clusteranalyse die Ressourcenzuweisung optimieren, indem sie Muster in räumlichen oder zeitlichen Daten identifiziert. Durch das Clustern von Lieferadressen oder Produktionsstätten auf der Grundlage ihrer geografischen Nähe können Unternehmen beispielsweise Transportkosten senken und dadurch die Gesamteffizienz verbessern. - Erleichterung des maschinellen Lernens und der prädiktiven Analyse

Die Clusteranalyse spielt eine entscheidende Rolle beim maschinellen Lernen und der prädiktiven Analyse, da sie als Vorverarbeitungsschritt für andere Techniken dient. Clustering reduziert zum Beispiel die Dimensionalität von Daten vor der Anwendung von Klassifizierungs- oder Regressionsalgorithmen. Diese Methode verbessert die Leistung und Genauigkeit von Vorhersagemodellen. Darüber hinaus hilft die Clusteranalyse dabei, Untergruppen innerhalb von Datensätzen zu identifizieren, die zur Entwicklung gezielterer maschineller Lernmodelle oder zur Erstellung differenzierterer Vorhersagen verwendet werden können.

Nachteile der Verwendung der Clusteranalyse

- Wahl der Abstandsmetrik und des Clustering-Algorithmus

Die Wirksamkeit der Clusteranalyse hängt von der Wahl der Abstandsmetrik und des Clustering-Algorithmus ab. Unterschiedliche Abstandsmetriken wie die euklidische, die Manhattan- oder die Kosinusähnlichkeit können zu unterschiedlichen Ergebnissen führen. Die Wahl der am besten geeigneten Metrik für Ihren Datensatz ist entscheidend, da eine ungeeignete Metrik zu schlechten Clustering-Ergebnissen oder einer Fehlinterpretation der Daten führen kann. - Empfindlichkeit gegenüber Anfangsbedingungen und Ausreißern

Einige Clustering-Algorithmen wie beispielsweise K-means reagieren empfindlich auf die Anfangsbedingungen. Das bedeutet, dass unterschiedliche Initialisierungen zu unterschiedlichen Clustering-Ergebnissen führen können. Die daraus entstehenden inkonsistenten Ergebnisse erschweren die Bestimmung einer optimalen Lösung. Auch Ausreißer können die Leistung von Clustering-Algorithmen erheblich beeinträchtigen. In einigen Fällen verzerren Ausreißer die Cluster, was zu ungenauen oder irreführenden Ergebnissen führt. Robuste Algorithmen, die mit Ausreißern umgehen können, wie z. B. DBSCAN, sind für solche Situationen möglicherweise besser geeignet. - Bestimmung der optimalen Anzahl von Clustern

Oft ist es schwierig, die optimale Anzahl von Clustern zu bestimmen. Bei einigen Algorithmen (zum Beispiel K-means) muss die Anzahl der Cluster im Voraus festgelegt werden. Die Benutzer müssen sich dann auf Heuristiken oder Validierungsmaße wie den Silhouetten-Score oder die Ellbogenmethode verlassen, um die optimale Anzahl von Clustern zu ermitteln. Diese Methoden liefern jedoch nicht immer eine endgültige Antwort. Sie sind interpretationsbedürftig. - Skalierbarkeit und Rechenkomplexität

Die Clusteranalyse wird insbesondere bei großen Datenmengen sehr rechen- und zeitaufwändig. Einige Algorithmen, zum Beispiel das hierarchische Clustering, haben eine hohe Rechenkomplexität, so dass sie für die Verarbeitung großer Datenmengen nicht geeignet sind. In solchen Fällen müssen die Benutzer möglicherweise effizientere Algorithmen in Betracht ziehen oder Techniken wie Dimensionalitätsreduktion oder Datensampling implementieren, um die Leistung zu verbessern.

Systematische Anwendung der Clusteranalyse

Die Analyse von Clustering-Daten ist ein entscheidender Schritt zur Aufdeckung verborgener Muster und Strukturen in Ihrem Datensatz. Wenn Sie systematisch vorgehen, können Sie aussagekräftige Gruppen identifizieren und wertvolle Erkenntnisse aus Ihren Daten gewinnen.

- Vorbereiten Ihrer Daten – Bevor Sie mit der Clusteranalyse beginnen, müssen Sie Ihre Daten bereinigen und vorverarbeiten. Dieser Prozess umfasst das Entfernen von Ausreißern, die Behandlung fehlender Werte und die Skalierung oder Normalisierung von Merkmalen. Eine ordnungsgemäße Datenvorbereitung stellt sicher, dass Ihre Clustering-Analyse genaue und aussagekräftige Ergebnisse liefert.

- Auswahl des richtigen Clustering-Algorithmus – Es gibt verschiedene Clustering-Algorithmen mit unterschiedlichen Stärken und Schwächen. Berücksichtigen Sie bei der Auswahl des am besten geeigneten Algorithmus die Stichprobengröße, die Verteilung und die Form Ihres Datensatzes. Denken Sie daran, dass kein einziger Algorithmus universell anwendbar ist. Wählen Sie denjenigen aus, der am besten zu Ihren spezifischen Datenmerkmalen passt.

- Bestimmung der optimalen Anzahl von Clustern – Für einige

Clustering-Algorithmen (zum Beispiel für K-means) müssen Sie die Anzahl der Cluster im Voraus

festlegen. Die Bestimmung der optimalen Anzahl von Clustern ist häufig eine Herausforderung.

Aber es gibt mehrere Methoden, die Ihnen bei Ihrer Entscheidung helfen können:

- Elbow-Methode: Stellen Sie die erklärte Varianz (oder die Summe der Quadrate innerhalb

von Clustern) gegen die Anzahl der Cluster. Suchen Sie nach dem

Ellenbogen

-Punkt, an dem das Hinzufügen weiterer Cluster nur marginale Verbesserungen bewirkt. - Silhouetten-Punktzahl: Berechnen Sie den Silhouetten-Score für verschiedene Anzahlen von Clustern und wählen Sie den mit dem höchsten Score.

- Gap-Statistik: Vergleichen Sie die Streuung innerhalb von Clustern mit einer Referenzverteilung und wählen Sie die Anzahl der Cluster, bei denen die Lücke am größten ist.

- Elbow-Methode: Stellen Sie die erklärte Varianz (oder die Summe der Quadrate innerhalb

von Clustern) gegen die Anzahl der Cluster. Suchen Sie nach dem

- Anwendung des Clustering-Algorithmus – Sobald Sie den geeigneten Algorithmus ausgewählt und die optimale Anzahl von Clustern bestimmt haben, wenden Sie den Algorithmus auf Ihren Datensatz an. Die meisten Programmiersprachen und Datenanalysetools, wie Python, R oder Excel, bieten integrierte Funktionen oder Bibliotheken für die Durchführung von Clusteranalysen. Stellen Sie sicher, dass Sie alle Algorithmus-spezifischen Parameter feinabstimmen, um die besten Ergebnisse zu erzielen.

Fazit

Die Clusteranalyse ist eine leistungsstarke Data-Mining-Technik, die verborgene Muster und Strukturen in großen Datensätzen aufdeckt, indem sie ähnliche Datenpunkte zu Gruppen zusammenfasst. Eine wesentliche Erkenntnis ist die Bedeutung des Verständnisses verschiedener Clustering-Algorithmen, von denen jeder seine eigenen Stärken und Schwächen hat.

Die Auswahl des am besten geeigneten Algorithmus für Ihren Datensatz (zum Beispiel K-means, hierarchisches Clustering, DBSCAN oder spektrales Clustering) entscheidet darüber, ob Sie aussagekräftige Ergebnisse erhalten. Darüber hinaus sind die Bestimmung der optimalen Anzahl von Clustern, die Vorbereitung der Daten und die Auswertung der Clustering-Ergebnisse entscheidende Schritte in diesem Prozess.

Erfahren Sie mehr über weitere Methoden der Datenanalyse in der MarktforschungFAQs zur Clusteranalyse

Was ist eine Clusteranalyse und warum ist sie wichtig?

Die Clusteranalyse ist eine Data-Mining-Technik, die ähnliche Datenpunkte auf der Grundlage ihrer Attribute gruppiert und so verborgene Muster und Strukturen in großen Datensätzen aufdeckt. Sie ermöglicht es Forschern und Unternehmen, wertvolle Erkenntnisse zu gewinnen, fundierte Entscheidungen zu treffen und Innovationen voranzutreiben.

Wie wähle ich den richtigen Clustering-Algorithmus für meine Daten?

Die Auswahl des richtigen Clustering-Algorithmus hängt von Faktoren wie Größe, Verteilung und Form des Datensatzes ab. Einige beliebte Algorithmen sind K-means, hierarchisches Clustering, DBSCAN und spektrales Clustering. Es ist wichtig, die Stärken und Schwächen der einzelnen Algorithmen zu kennen und einen Algorithmus zu wählen, der optimal zu den einzigartigen Eigenschaften Ihrer Daten passt.

Wie kann ich die optimale Anzahl von Clustern für meinen Datensatz bestimmen?

Verschiedene Methoden können Ihnen bei der Entscheidungsfindung helfen, z. B. die Elbow-Methode, der Silhouette Score und die Gap-Statistik. Jede Methode zielt darauf ab, die Anzahl von Clustern zu ermitteln, die die Kohäsion innerhalb der Cluster und die Trennung zwischen den Clustern maximiert, was zu aussagekräftigen und interpretierbaren Ergebnissen führt.

Wie analysiere ich Clusterdaten?

Die Bewertung von Clustering-Ergebnissen kann durch visuelle Inspektion erfolgen, indem Datenpunkte geplottet und auf der Grundlage von Cluster-Zuordnungen farblich kodiert werden. Auch Metriken wie Silhouette Score und Adjusted Rand Index (ARI) können zur Messung der Clustering-Leistung verwendet werden. Visualisierungen wie Streudiagramme, Heatmaps oder Dendrogramme geben ebenfalls Einblicke in die Beziehungen zwischen Datenpunkten und die allgemeine Datenstruktur.